L’IA est-elle juste avec tout le monde?

Cet article fait partie de notre nouvelle série: IA-tu pensé?, dans laquelle on t’explique tout ce que tu dois savoir sur cette nouvelle technologie: évolution, forces, limites, impact, pour que tu puisses réfléchir sur sa place dans la société!

Une machine peut-elle avoir des préférences? On dit souvent que l’intelligence artificielle (IA) est objective, parce qu’elle n’a pas d'émotion, d’opinion ou de préjugé. Pourtant, ce n’est pas si simple. Je t’explique!

L’IA n’invente rien toute seule: elle apprend à partir de données produites par les humains. Et si ces données ne représentent pas tout le monde de façon équitable, l’IA développe ce qu’on appelle des biais de représentativité: elle hérite des préjugés des humains qui ont produit ou sélectionné le contenu sur lequel l’algorithme est entraîné.

La représentatita… quoi?

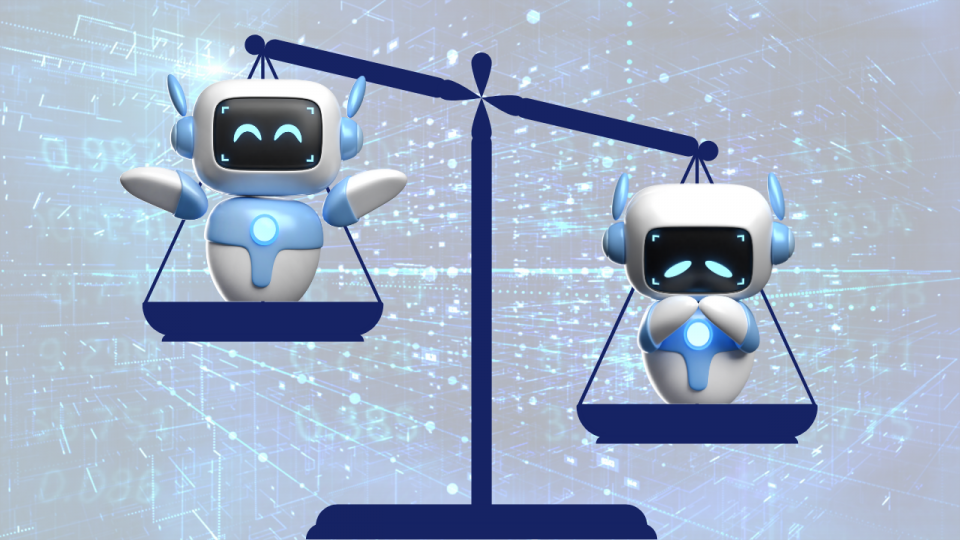

Un biais de représentativité se produit lorsqu’un groupe de personnes est mal représenté dans les données utilisées pour entraîner une IA. Autrement dit, l’IA reçoit beaucoup d’exemples de certaines personnes, mais peu d’exemples d’autres. Résultat: elle devient très performante pour reconnaître ou comprendre un certain groupe, mais beaucoup moins pour les autres.

Par exemple, lors de l’entraînement, si 9 photos de médecins sur 10 qu’on donne à l’IA montrent des personnes blanches, l’algorithme associera le mot «médecin» à des personnes blanches. Et à l’avenir, quand on lui demandera de créer une image représentant un médecin, par exemple, l’IA risque de ne pas inclure de personne noire, arabe, asiatique.... Même si ce métier est en réalité aussi pratiqué par des gens de toutes les origines.

Pourquoi est-ce un problème?

Ce biais a des conséquences bien réelles: il renforce les inégalités déjà existantes dans notre société.

Par exemple, certaines entreprises utilisent l’IA pour trier rapidement les CV. Le but est de gagner du temps et de trouver plus facilement de bons candidats. C’est le cas de la compagnie Amazon, qui avait entraîné une IA avec les profils de personnes embauchées dans les 10 années précédentes.

Or, la majorité de ces employés étaient des hommes. Résultat: l’IA «apprenait» qu’être un homme était un critère important, et elle pénalisait automatiquement les candidatures de femmes, même si elles avaient les mêmes compétences. Si un humain utilise l’IA sans corriger ces préjugés, cela peut désavantager gravement des personnes dans le monde réel.

Je te rassure: Amazon n’utilise plus ce programme!

Existe-t-il des solutions?

La première étape, c’est de connaître l’existence de ce biais. Si les programmeurs savent que le problème existe, ils peuvent entraîner les IA avec des données qui prennent en compte toute la diversité.

En santé, par exemple, l’Organisation mondiale de la santé (OMS) recommande que les données utilisées tiennent compte du genre, de l’âge et de l’origine ethnique des personnes, afin que l’IA puisse mieux servir tout le monde.

Mais le plus important, c’est d’user de notre jugement: une force que nous avons, les humains! Il faut toujours remettre en question le résultat donné par une IA et avoir conscience des potentiels biais présents dans les données d’entraînement.

Selon toi, peut-on dire que l’IA est «injuste» si elle reproduit ce qu’elle a appris des humains?

En remerciant, pour son apport au contenu, M. Julien Besset, vulgarisateur scientifique chez